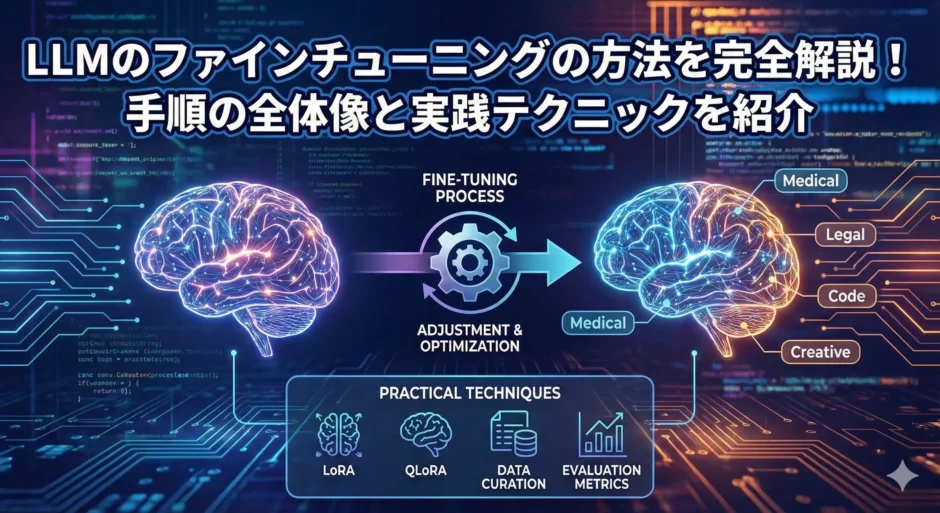

大規模言語モデル(LLM)のファインチューニングは、近年のAI開発において欠かせないプロセスとなっています。

この記事では、「llm ファインチューニング 方法」をテーマに、基礎から応用、そして実務での活用までを体系的に分かりやすく解説します。

あなたのプロジェクトに最適な手法を選び、効率的に性能を最大化するための知識を身につけましょう。

LLMのファインチューニングの方法とは何かを基礎から理解しよう

ファインチューニングは、事前学習済みの大規模言語モデルを特定の用途に適応させる重要な工程です。

まずはLLMの基本構造や特性を理解し、なぜ微調整が成果を左右するのかを知ることが成功への第一歩になります。

ベースとなる仕組みを押さえると、後に紹介する実践的な手法もスムーズに理解できるでしょう。

LLM(大規模言語モデル)の基本構造と特徴

LLMは、数百億から数千億のパラメータを持ち、膨大なテキストデータを学習して自然言語を理解・生成するモデルです。

代表的な構造はTransformerアーキテクチャで、自己注意機構により文脈全体を捉えながら柔軟に応答を生成します。

その汎用的な性質のおかげで、翻訳、要約、質問応答など多様なタスクに対応可能です。

ただし、汎用的であるがゆえに、特定ドメインへの最適化には微調整が不可欠になります。

ファインチューニングの役割とメリット

ファインチューニングは、特定用途向けにモデルを再学習させることで、精度を高める工程です。

例えば、金融専門の問い合わせ応答や医療相談など、領域固有の知識を反映させることができます。

これにより、応答の一貫性や信頼性が向上し、ユーザー体験も大きく改善されます。

汎用モデルをそのまま使うよりも計算コストを抑えながら、より正確な結果を得られるのが特徴です。

事前学習モデルとの違いと関係性

事前学習モデルは広範なデータから一般的な言語知識を獲得した状態です。

一方でファインチューニングは、既に学習済みの知識土台を活かしつつ、特定タスク向けに調整を行うプロセスです。

両者は補完関係にあり、大規模な汎用学習があるからこそ効率的な微調整が可能になります。

基礎性能と応用性能のバランスを取ることが成果に直結します。

LLMがファインチューニングの方法で強化されるポイント

ファインチューニングを行うことで、モデルは特定の言語スタイルや業界用語に精通します。

さらに、入力の曖昧さを減らし、生成結果の一貫性が高まる効果も得られます。

また、ユーザーとの対話履歴を活かすことで応答の自然さや文脈理解も強化されます。

こうした累積効果により、モデルの価値が飛躍的に向上します。

LLMのファインチューニングの方法を選ぶ前に押さえたい導入準備

ファインチューニングを成功させるには、準備段階の精度が重要です。

目的設定、モデル選定、データ整備、そして学習環境の確認という4つの柱を押さえることで、無駄のない実装が可能になります。

ここでは導入前に準備すべきポイントを整理しておきましょう。

用途に合ったベースモデルを選定する基準

モデル選定では、「精度・サイズ・ライセンス・計算コスト」の4要素を見極めます。

小規模プロジェクトなら軽量モデルを、生成精度重視ならパラメータ数の多いLLMが適しています。

オープンソースのモデルを選べば柔軟なカスタマイズが可能ですが、サポート体制の確認も大切です。

最終的な判断は、タスク内容と運用リソースを総合的に比較して行います。

学習データを収集してクレンジングする手順

データ品質はファインチューニングの出来を決定づけます。

まず目的に合ったデータを収集し、ノイズの除去や重複排除、形式統一などを実施します。

誤字、感情表現の偏り、公序良俗に反する内容などを丁寧にフィルタリングしましょう。

データクリーニング後は、適切なフォーマット(JSONやCSVなど)に変換して準備完了です。

GPU環境やクラウドなどハードウェア要件を確認する

ファインチューニングには高い計算資源が求められることがあります。

利用できるGPUメモリ、ストレージ容量、クラウドコストを事前に把握しておくことが大切です。

特にコスト管理の観点から、分散学習やオンデマンドGPUの利用も検討しましょう。

効率的な環境設計が学習速度と再現性を高めます。

Hugging Faceや各種フレームワークを比較して選ぶ

代表的なライブラリにはHugging Face Transformers、PEFT、DeepSpeedなどがあります。

Hugging Faceは豊富なモデルと直感的なAPIが魅力で、初心者にも扱いやすいです。

一方、企業レベルの開発ではPyTorchやTensorFlowが採用されるケースも多くあります。

目的とスキルレベルに応じて、最適なツールを選定しましょう。

LLMのファインチューニングの方法を実践するための具体的な手順

ここからはファインチューニングを実際に行う際の流れを説明します。

データセット分割からパラメータ設定、学習の進行、評価までの一連の工程を理解すれば、高品質なモデルを構築できます。

データセットを分割して品質をチェックする方法

データはトレーニング・検証・テストの3つに分けます。

一般的な比率は8:1:1ですが、データ量に応じて調整可能です。

その際に、ラベルの偏りやデータ重複がないかを確認します。

品質チェックを怠ると学習精度が低下するため、最初の整備工程は特に慎重に進めましょう。

学習率やバッチサイズなどハイパーパラメータを設定する

学習率はモデルの安定性を決める重要なパラメータです。

大きすぎると発散し、小さすぎると収束が遅くなります。

また、バッチサイズはメモリ使用量に直結するため、GPU性能を踏まえて設定します。

トライアルを重ね、最もバランスが取れた値を見つけることが肝要です。

トレーニングを実行してログで進捗をモニタリングする

学習を開始したら、損失関数の推移や精度指標を定期的に確認します。

ログはTensorBoardやWeights & Biasesなどの可視化ツールで管理すると便利です。

異常値や急激な変化が見られた場合は、早めに学習計画を見直しましょう。

安定したログ解析が成功への近道となります。

検証データでモデル性能を評価してチューニングする

学習後は検証データを用いて性能を評価します。

指標には精度(Accuracy)、再現率(Recall)、F1スコアなどを活用します。

スコアが目標を満たさない場合はデータ構成やハイパーパラメータを再調整します。

この反復工程により精度を最大限引き上げることができます。

LLMのファインチューニングの方法を効率化する軽量学習テクニック

近年は計算コストを抑えつつ高性能を維持する技術が注目を集めています。

LoRAやAdapterなどの手法を活用すれば、限られたリソースでも実用的な精度を確保できるでしょう。

LoRAを使ってパラメータを効率的に更新する仕組み

LoRA(Low-Rank Adaptation)は、モデル全体ではなく一部の重み行列のみを更新する手法です。

この仕組みによりパラメータ更新量を大幅に削減でき、学習時間も短縮されます。

元のモデル構造を保持したまま再利用できる点も利点です。

特に大規模モデルを扱う際に、高効率でコストパフォーマンスの高い選択肢になります。

AdapterやPrefix Tuningなどの代表的な手法の特徴

Adapterはネットワーク層の間に小さなモジュールを追加し、モデル全体を再学習せず特定層のみを微調整します。

Prefix Tuningは入力トークンに追加のパラメータを付与して文脈制御を実現します。

どちらもパラメータ数を大幅に削減しながら、高精度な出力を得るのに有効です。

用途とモデル規模に応じて最適な方法を選ぶことが推奨されます。

低リソース環境でコストを抑えるための工夫

学習コストを下げるには、ミニバッチ処理や勾配累積、量子化などを組み合わせるのが効果的です。

また、ハーフプレシジョン(FP16)など軽量計算方式を用いるとメモリ効率も高まります。

クラウドサービスをスポットインスタンスで利用すればコストをさらに最適化できます。

限られた予算でも十分に結果を出すための現実的な戦略といえます。

小規模データでも精度を落とさないための設計ポイント

データが少ない場合は、データ拡張や自己学習を取り入れることが有効です。

また、トランスファーラーニングを行うことで過学習を防ぎながら性能を維持できます。

サンプリングバランスや正則化手法も組み合わせると安定した結果につながります。

データ量に左右されない設計が現場での成功を左右する要素です。

LLMのファインチューニングの方法を最適化するための評価と改善のコツ

モデルの性能を長期的に維持するには、評価と改善のサイクルを設計することが欠かせません。

ここでは過学習防止や定量的評価、エラー分析のプロセスを解説します。

過学習を防ぐための正則化や早期終了の使い方

過学習はトレーニングデータに特化しすぎることで汎用性が失われる現象です。

ドロップアウトやL2正則化を導入することで過学習を防げます。

また、検証損失の改善が止まった時点で学習を終了する「早期終了」も効果的です。

モデルの一般化性能を維持するために、学習過程を常にモニタリングしましょう。

評価指標を選んで定量的にモデルを比較する方法

モデルの改善には正しい評価指標の選択が鍵になります。

分類タスクならPrecisionやF1スコア、生成タスクならBLEUやROUGEが代表的です。

目的に応じて複数指標を併用し、スコアを総合的に分析します。

定量的評価はチーム内での意思決定にも役立ちます。

エラー分析から改善点を洗い出すプロセス

誤生成例を分析し、どのケースで失敗しているのかを特定します。

分野固有の言語表現や構文パターンを学習できていない場合も多いです。

これらを補うデータを追加学習することで性能改善が可能です。

定性的な分析を続けることで、モデル理解もより深まります。

継続学習でモデル性能を長期的に安定させる手法

継続学習は、新データを少しずつ学習させてモデルの劣化を防ぐ方法です。

完全再学習に比べてコストが低く、運用フェーズでの精度維持に効果的です。

ただし、既存知識の破壊(忘却)を防ぐために学習率設定が重要です。

段階的な更新を計画的に実行して、モデルの進化を継続させましょう。

LLMのファインチューニングの方法で使えるツールと実務ケーススタディ

ファインチューニングを現場で活かすには、ツール理解と実例分析が役立ちます。

各種フレームワークや事例を把握することで、自社に合った最適解を見つけられます。

Hugging Face TransformersとPEFTの活用パターン

Hugging Faceは豊富なプリトレインモデルを提供し、わずかなコードで微調整が可能です。

PEFT(Parameter-Efficient Fine-Tuning)は効率的なファインチューニング実装を支援します。

両者を組み合わせることで、環境構築の手間を最小限に抑えつつ高品質な結果を得られます。

学習ログやモデル管理も統合的に扱える点が魅力です。

企業システムへの組み込み事例から学べるポイント

企業ではチャットボット、自動要約、FAQ運用などでLLMが活用されています。

特定分野に特化したデータでファインチューニングし、業務効率化を実現しているケースも多くあります。

導入の際はデータガバナンスやセキュリティ要件を明確にすることが重要です。

成功事例を分析することで導入計画の参考にできます。

オープンソースモデルを採用するときの注意点

オープンソースモデルは自由度が高い一方で、ライセンスや更新サイクルの確認が不可欠です。

外部データ利用時の著作権問題にも配慮する必要があります。

また、モデル品質が保証されない場合もあるため、社内検証を必ず行いましょう。

リスクを把握した上で利点を最大化する姿勢が求められます。

最新研究動向やモデルアップデートへの追随方法

AI分野の進化は非常に早く、新たな手法が次々に登場しています。

論文やGitHubリポジトリを定期的にチェックして動向を把握しましょう。

学会発表やオープンソースコミュニティへの参加も有用です。

最新技術への継続的な関心が競争力を生みます。

LLMのファインチューニングの方法を安全に運用するためのリスクと対策

AI活用には倫理・法的リスクが伴います。

安全で責任ある運用を実現するためには、データ保護、バイアス軽減、セキュリティ設計を意識することが不可欠です。

学習データの著作権とプライバシー保護の考え方

データには著作権や個人情報が含まれる可能性があるため、利用許諾の確認を怠ってはいけません。

匿名化処理や権利者情報の管理を徹底しましょう。

法令遵守の観点からも、安全なデータ利用ポリシーを整備することが必要です。

透明性の高い運用が信頼性を高めます。

バイアスを検出して軽減するためのチェックポイント

学習データに偏りがあると、モデル出力にも偏見が生まれます。

データ分布を可視化し、出力をテストして差異を検出します。

必要に応じて対照的なサンプルを追加し、公平性を高めます。

社会的影響を考慮した評価プロセスが求められます。

機密情報を扱う際のセキュリティ設計の注意点

企業内部のデータを扱う場合は、アクセス制御や暗号化が必須です。

APIキーやトークンを安全に管理し、不正利用を防止します。

クラウド環境ではリージョン設定や通信経路の暗号化も重要です。

事前のリスク設計が重大な情報漏えいを防ぐ鍵となります。

本番運用でのモニタリングとリスクマネジメント

運用開始後もモデル挙動を継続的に監視し、異常検知システムを導入します。

フィードバックループを設計すれば、モデルの品質維持が容易になります。

リスク発生時の対応マニュアルを整備し、即時の対処が可能な体制を整えましょう。

安定運用のための体制構築も技術と同じくらい重要です。

LLMのファインチューニングの方法を理解して自社プロジェクトに活用しよう

ここまで見てきたように、LLMのファインチューニングは単なる技術ではなく、戦略的な資産形成のプロセスです。

正しい手順と適切な評価、継続的な改善を実践すれば、自社業務に特化した最強のAIパートナーを構築できます。

今こそ知識を実践に落とし込み、次世代のAI活用でビジネス価値を高めましょう。